文章目录

- 区别

- 传统的自注意力机制

- 交叉注意力机制

- 区别总结

- 应用实例

- 自注意力机制的应用:

- 交叉注意力机制的应用:

- 代码

- 自注意力机制的实现

- 交叉注意力机制的实现

- 说明

- 交叉注意力机制的发展趋势

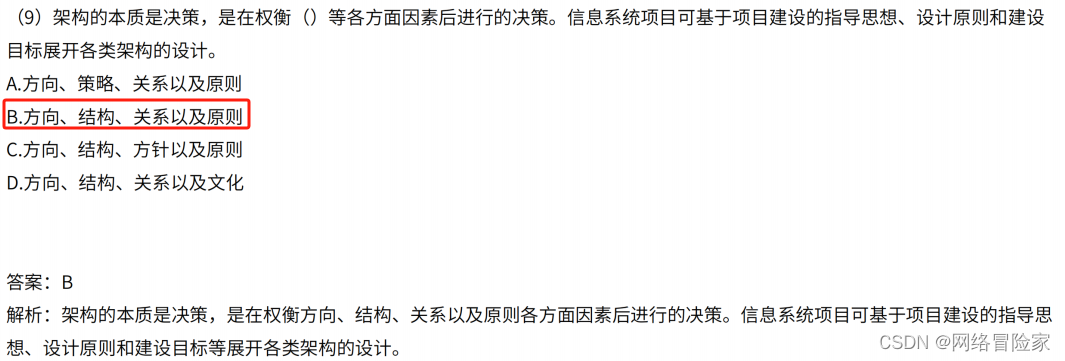

区别

交叉注意力机制(Cross-Attention Mechanism)和传统的自注意力机制(Self-Attention Mechanism)都是深度学习模型中用于处理注意力(Attention)的重要技术,特别是在自然语言处理(NLP)和计算机视觉(CV)领域。

传统的自注意力机制

自注意力机制(Self-Attention Mechanism)是由Vaswani等人在2017年的论文“Attention is All You Need”中提出的,主要用于Transformer模型中。它的主要目的是让每个输入元素在计算输出时都能够关注输入序列中的其他所有元素。这种机制广泛应用于各种任务,如机器翻译、文本生成和图像处理等。

自注意力机制的计算过程主要包括以下几个步骤:

- 输入处理:给定输入序列 X = [ x 1 , x 2 , … , x n ] X = [x_1, x_2, \ldots, x_n] X=[x1,x2,…,xn]。

- 计算查询、键和值(Query, Key, Value):

Q = X W Q , K = X W K , V = X W V Q = XW_Q, \quad K = XW_K, \quad V = XW_V Q=XWQ,K=XWK,V=XWV

其中, W Q , W K , W V W_Q, W_K, W_V WQ,WK,WV 是可学习的参数矩阵。 - 计算注意力权重:通过点积计算查询和键的相似度,并进行缩放和软最大化处理:

Attention ( Q , K , V ) = softmax ( Q K T d k ) V \text{Attention}(Q, K, V) = \text{softmax}\left(\frac{QK^T}{\sqrt{d_k}}\right)V Attention(Q,K,V)=softmax(dkQKT)V

其中, d k d_k dk 是键向量的维度。

交叉注意力机制

交叉注意力机制(Cross-Attention Mechanism)主要用于处理多模态任务或需要对不同来源的输入进行关联的场景。其核心思想是一个输入序列的元素关注另一个输入序列的元素,从而在不同的输入间建立联系。

与自注意力机制的主要区别在于,交叉注意力机制处理的是不同的输入序列。例如,在图像字幕生成任务中,文本序列需要关注图像的特征,交叉注意力机制能够将图像特征与文本特征关联起来。

交叉注意力机制的计算过程如下:

- 输入处理:给定两个输入序列 X = [ x 1 , x 2 , … , x n ] X = [x_1, x_2, \ldots, x_n] X=[x1,x2,…,xn] 和 Y = [ y 1 , y 2 , … , y m ] Y = [y_1, y_2, \ldots, y_m] Y=[y1,y2,…,ym]。

- 计算查询、键和值:

Q = X W Q , K = Y W K , V = Y W V Q = XW_Q, \quad K = YW_K, \quad V = YW_V Q=XWQ,K=YWK,V=YWV

其中, W Q , W K , W V W_Q, W_K, W_V WQ,WK,WV 是可学习的参数矩阵。 - 计算注意力权重:通过点积计算查询和键的相似度,并进行缩放和软最大化处理:

Attention ( Q , K , V ) = softmax ( Q K T d k ) V \text{Attention}(Q, K, V) = \text{softmax}\left(\frac{QK^T}{\sqrt{d_k}}\right)V Attention(Q,K,V)=softmax(dkQKT)V

这里与自注意力机制不同的是, Q Q Q 来自一个输入序列,而 K K K 和 V V V 来自另一个输入序列。

区别总结

- 输入序列:自注意力机制在同一个输入序列内建立注意力,交叉注意力机制在不同的输入序列间建立注意力。

- 应用场景:自注意力机制多用于单一模态的任务(如纯文本任务),交叉注意力机制多用于多模态任务(如图像和文本的结合)。

- 计算过程:自注意力机制的查询、键和值都来自同一个输入序列,而交叉注意力机制的查询来自一个输入序列,键和值来自另一个输入序列。

应用实例

自注意力机制的应用:

- 机器翻译:Transformer模型中,编码器和解码器都使用自注意力机制来捕捉句子内部的依赖关系。

交叉注意力机制的应用:

- 图像字幕生成:在图像字幕生成模型中,交叉注意力机制让文本生成器能够关注图像特征,从而生成描述图像内容的文本。

通过这些机制的应用,深度学习模型在处理复杂任务时能够更加准确地捕捉输入数据中的相关性和依赖性,从而提升性能。

代码

下面是一个简单的例子,展示了如何在PyTorch中实现自注意力机制和交叉注意力机制。这个例子使用了一个简化的Transformer结构。

自注意力机制的实现

首先,我们实现一个简单的自注意力机制:

import torch

import torch.nn as nn

import torch.nn.functional as F

class SelfAttention(nn.Module):

def __init__(self, embed_size, heads):

super(SelfAttention, self).__init__()

self.embed_size = embed_size

self.heads = heads

self.head_dim = embed_size // heads

assert (

self.head_dim * heads == embed_size

), "Embedding size needs to be divisible by heads"

self.values = nn.Linear(self.head_dim, self.head_dim, bias=False)

self.keys = nn.Linear(self.head_dim, self.head_dim, bias=False)

self.queries = nn.Linear(self.head_dim, self.head_dim, bias=False)

self.fc_out = nn.Linear(heads * self.head_dim, embed_size)

def forward(self, values, keys, query, mask):

N = query.shape[0]

value_len, key_len, query_len = values.shape[1], keys.shape[1], query.shape[1]

# Split the embedding into self.heads different pieces

values = values.reshape(N, value_len, self.heads, self.head_dim)

keys = keys.reshape(N, key_len, self.heads, self.head_dim)

queries = query.reshape(N, query_len, self.heads, self.head_dim)

values = self.values(values)

keys = self.keys(keys)

queries = self.queries(queries)

energy = torch.einsum("nqhd,nkhd->nhqk", [queries, keys])

if mask is not None:

energy = energy.masked_fill(mask == 0, float("-1e20"))

attention = torch.softmax(energy / (self.embed_size ** (1 / 2)), dim=3)

out = torch.einsum("nhql,nlhd->nqhd", [attention, values]).reshape(

N, query_len, self.heads * self.head_dim

)

out = self.fc_out(out)

return out

embed_size = 256

heads = 8

values = torch.rand(32, 10, embed_size) # (batch_size, sequence_length, embed_size)

keys = torch.rand(32, 10, embed_size)

queries = torch.rand(32, 10, embed_size)

mask = None

self_attention = SelfAttention(embed_size, heads)

out = self_attention(values, keys, queries, mask)

print(out.shape) # Should output: torch.Size([32, 10, 256])

交叉注意力机制的实现

接下来,我们实现一个简单的交叉注意力机制:

class CrossAttention(nn.Module):

def __init__(self, embed_size, heads):

super(CrossAttention, self).__init__()

self.embed_size = embed_size

self.heads = heads

self.head_dim = embed_size // heads

assert (

self.head_dim * heads == embed_size

), "Embedding size needs to be divisible by heads"

self.values = nn.Linear(self.head_dim, self.head_dim, bias=False)

self.keys = nn.Linear(self.head_dim, self.head_dim, bias=False)

self.queries = nn.Linear(self.head_dim, self.head_dim, bias=False)

self.fc_out = nn.Linear(heads * self.head_dim, embed_size)

def forward(self, values, keys, query, mask):

N = query.shape[0]

value_len, key_len, query_len = values.shape[1], keys.shape[1], query.shape[1]

values = values.reshape(N, value_len, self.heads, self.head_dim)

keys = keys.reshape(N, key_len, self.heads, self.head_dim)

queries = query.reshape(N, query_len, self.heads, self.head_dim)

values = self.values(values)

keys = self.keys(keys)

queries = self.queries(queries)

energy = torch.einsum("nqhd,nkhd->nhqk", [queries, keys])

if mask is not None:

energy = energy.masked_fill(mask == 0, float("-1e20"))

attention = torch.softmax(energy / (self.embed_size ** (1 / 2)), dim=3)

out = torch.einsum("nhql,nlhd->nqhd", [attention, values]).reshape(

N, query_len, self.heads * self.head_dim

)

out = self.fc_out(out)

return out

embed_size = 256

heads = 8

values = torch.rand(32, 10, embed_size) # e.g., features from an image

keys = torch.rand(32, 10, embed_size)

queries = torch.rand(32, 20, embed_size) # e.g., tokens from a text

mask = None

cross_attention = CrossAttention(embed_size, heads)

out = cross_attention(values, keys, queries, mask)

print(out.shape) # Should output: torch.Size([32, 20, 256])

说明

- 自注意力机制中的

values、keys和queries都来自同一个输入序列。 - 交叉注意力机制中的

queries来自一个输入序列(例如文本),而values和keys来自另一个输入序列(例如图像)。

这两个例子展示了如何在PyTorch中实现这些注意力机制。通过这些机制,可以让模型在处理复杂任务时,更好地捕捉输入数据中的相关性和依赖性,从而提升性能。

交叉注意力机制的发展趋势

交叉注意力机制(Cross-Attention Mechanism)在深度学习中的发展趋势显现出几个显著方向,主要体现在其在多领域的广泛应用及性能优化上。

首先,交叉注意力机制在大规模语言模型(LLMs)中已经显示出其重要性。LLMs通过预训练和迁移学习两个阶段来优化模型参数,从而在不同任务间实现无缝转移。交叉注意力在这些模型中帮助捕捉长距离依赖,提高了模型在处理复杂文本数据时的准确性和效率【8†source】。

其次,在图像分类和计算机视觉领域,交叉注意力机制也展示了其强大的潜力。例如,最新的研究提出了交叉和对角网络(CDNet),这是一种间接自注意力机制,通过计算不同方向上的注意力(垂直和对角),在捕捉图像全局信息的同时保留局部细节,从而显著提高了图像分类任务的性能和计算效率【10†source】。

在稳定扩散模型(Stable Diffusion)中,交叉注意力机制被用于创建“记忆”,使模型能够更有效地关注输入结构的关键方面,从而提高输出的准确性。这种方法不仅提高了模型的效率,还扩大了其在更大和更复杂任务中的应用前景【9†source】。

此外,交叉注意力机制在医疗领域也有广泛应用。例如,在医疗图像的诊断中,交叉注意力算法可以有效地解释复杂的医疗图像,辅助早期发现疾病,如癌症和肺部疾病。这种方法通过使模型关注图像的相关区域,提高了诊断的准确性【9†source】。

未来,交叉注意力机制的发展将继续关注于优化其计算效率和扩展其在不同领域的应用范围。这包括开发更高效的算法以降低计算成本,同时提高模型的准确性和可靠性。此外,随着深度学习模型的复杂性和规模不断增加,交叉注意力机制将在处理大规模数据和复杂任务中扮演越来越重要的角色【7†source】【8†source】。

总之,交叉注意力机制正逐步成为深度学习领域的重要工具,其在提高模型性能、扩展应用场景和优化计算效率方面的潜力巨大。随着研究的不断深入,我们可以期待这一技术在更多实际应用中的突破和创新。